Virtuelle Sensorik

Die Kamera wird zum essentiellen Sensor, die Fähigkeiten der Computer Vision definieren wesentlich den Einsatzbereich und die Fertigkeiten des Roboters. Getrieben durch Smartphones sind heute extrem kleine, leistungsstarke und günstige Kameras verfügbar. Dementsprechend sind bei manchen Servicerobotern bereits eine Vielzahl von Kameras verbaut. Die benötigte Rechenleistung und Algorithmik haben zwar hohe Anforderungen, werden jedoch branchenübergreifend genutzt. In komplexen Anwendungen steigt allerdings auch der Bedarf an weiteren Sensoren. Da diese überall im Körper des Roboters verbaut werden müssen, kommt es so schnell zu einer Komplexitätsexplosion der Sensorhardware und deren Verkabelung. Auch hier können Kamerasysteme helfen: Sensoren lassen sich virtuell als Softwaremodul implementieren, das Kamerabilder des Roboters selbst auswertet.

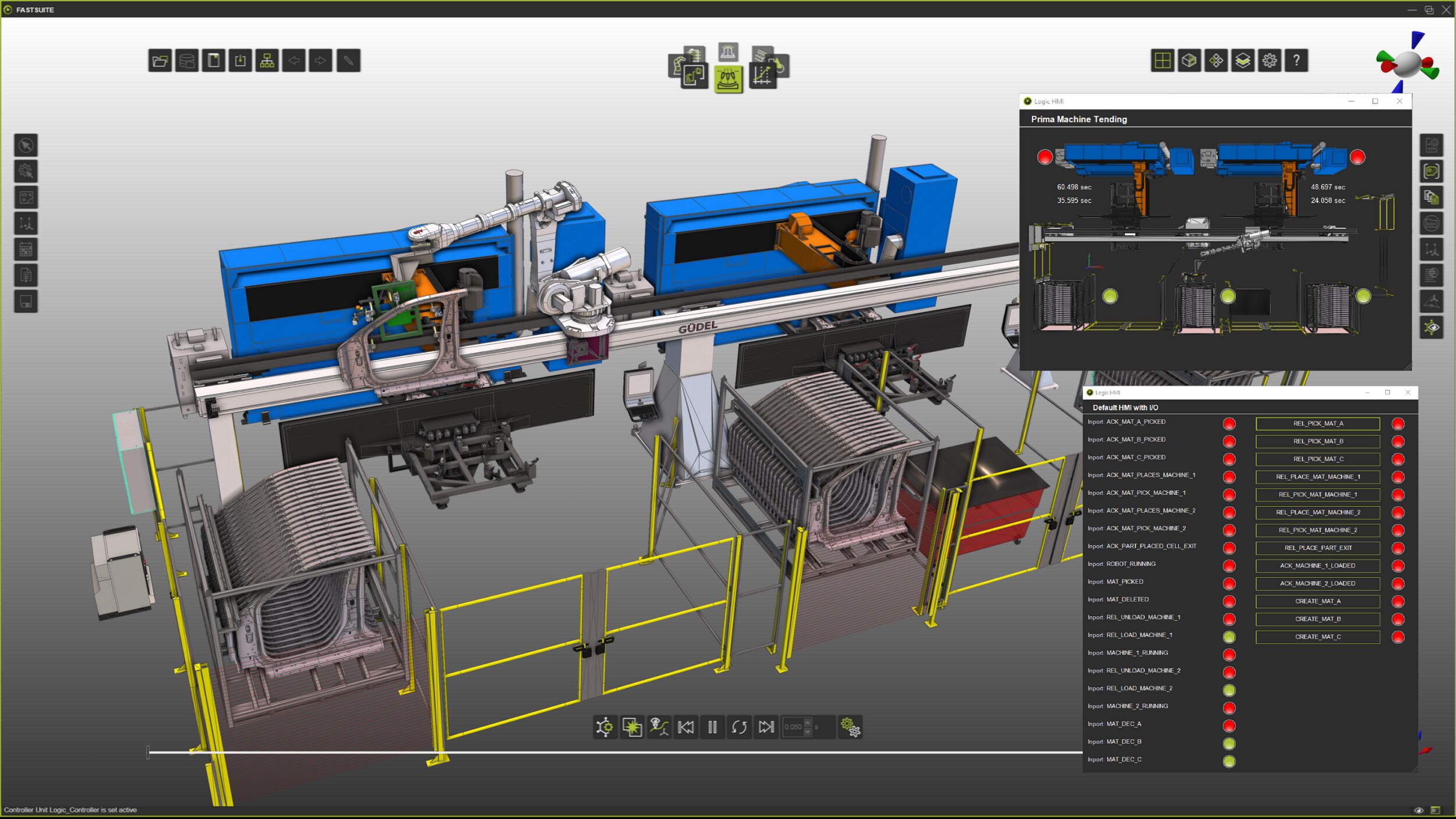

Funktionsprinzip der Sensorsoftware: Eine externe Kamera beobachtet die an Arm, Handgelenk und Greifer angebrachten Texturen. Diese dienen der Winkelerfassung (Gelenke des Arms), der Kraft/Momentensensorik (Handgelenk) und der taktilen Sensorik (am Greifer). (Bild: Visevi Robotics GmbH)

Visevi Robotics, ein Spin-off der Technischen Universität München, bietet die kamerabasierte Sensorik ViseTac für taktile Daten (Berührung), ViseForce für Kraft-Momente und ViseJoint für Winkelstellungen von Robotergelenken an. Virtuelle Winkel-Encoder lassen sich direkt durch die Erfassung von Positionen und Bewegungen des Roboterarms im Bild realisieren. Kraftmessungen erfolgen indirekt über passive elastische Elemente am Roboter, deren Verformung beobachtet wird.

Die Sensorsoftware kommt ohne aktive Module am Roboter aus, und ermöglicht stattdessen eine Fernmessung über eine oder mehrere Kameras mithilfe einer Bildverarbeitungssoftware. So wird quasi Fühlen durch Sehen für den Roboter möglich und die Sensorfunktionen verlagern sich vom Hardwaremodul in die Software. Es handelt sich also um reine Softwaresensoren. Am Roboter selbst sind nur noch passive Marker (visuelle Marker) und elastische Elemente nötig, die kostengünstig realisiert und auch im Roboter integriert werden können. Die Position und Lage dieser Elemente sowie gegebenenfalls deren Verformung werden im Kamerabild erfasst. Aus diesen Informationen berechnet die Software die Stellung des Arms im Raum sowie die wirkenden Kräfte bzw. Kontaktkräfte.

Bereits in Servicerobotern verbaute Kameratechnik ist auch für die Sensorsoftware nutzbar, da hierfür die Positionierung der Kamera flexibel ist. Die Bilder werden also gleichzeitig für verschiedene Algorithmen genutzt, zusätzliche Kameras sind häufig nicht nötig. Es muss nur sichergestellt werden, dass eine Beobachtung der passiven bzw. elastischen Elemente möglich ist. Durch die Nutzung mehrerer Kameras (z.B. Stereokameras) kann die Sichtbarkeit in allen relevanten Konfigurationen sichergestellt werden. Die Kamera kann also dort angebracht werden, wo eine Verkabelung kostengünstig möglich ist, wie z.B. am Kopf eines intelligenten Roboters.

Revolution in der Servicerobotik

Durch eine vollständig kamerabasierte Erkennung der Umgebung und des Roboterarms selbst ergeben sich eine Reihe weiterer Vorteile, wie kohärente Sensordaten, automatische Kalibrierung zum Objekt, geringeres Gewicht und massiv reduzierte Hardwarekomplexität. Bis auf die Kamera lassen sich so sensorlose, aber trotzdem präzise und sensitive Roboterarme aufbauen. Deren Anwendungen – wie ultra-leichte Arme für Drohnen, mobile Manipulatoren für Lieferroboter, oder Lowcost-Reinigungsroboter für den Heimbereich – zeigen eine wahre Revolution der Robotik auf.